Nowe formaty precyzji i optymalizacje pamięci

Najważniejszym elementem nowej platformy jest pełne wsparcie dla akceleratorów AMD Instinct MI350, które bazują na architekturze CDNA 4. Te procesory graficzne stworzono specjalnie z myślą o obciążeniach związanych ze sztuczną inteligencją, oferując znacznie większą wydajność niż standardowe karty graficzne.

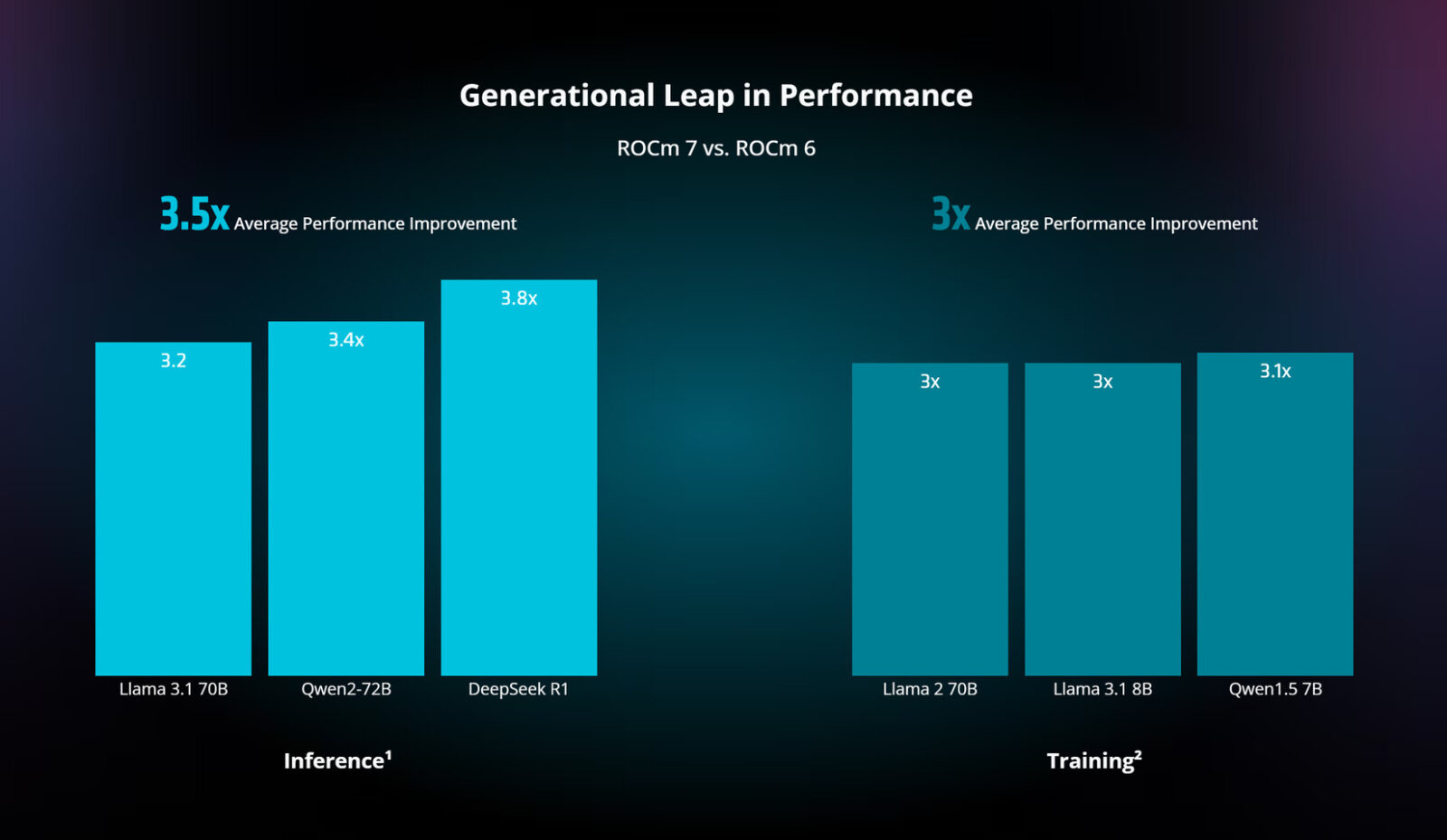

Wzrost wydajności nie wynika z przypadku. AMD wprowadza szereg usprawnień na poziomie sprzętowym, w tym zaawansowane wykorzystanie pamięci HBM i rozszerzoną obsługę typów danych. Równie istotne są optymalizacje programistyczne, które poprawiają przepustowość zarówno dla uczenia maszynowego, jak i wnioskowania.

Czytaj też: Sztuczna inteligencja wywołuje kryzys pamięci masowej. Dyski SSD zastępują tradycyjne HDD

Wsparcie dla formatów precyzji FP4, FP6 i FP8 to jedna z bardziej praktycznych nowości. Te formaty umożliwiają znaczące oszczędności pamięci kosztem minimalnej utraty dokładności, to kompromis, który w wielu zastosowaniach sztucznej inteligencji okazuje się niezwykle korzystny. Pamięć często stanowi wąskie gardło w obliczeniach AI. Nowoczesne modele językowe mogą wymagać setek gigabajtów RAM, co sprawia, że każda optymalizacja w tym obszarze przekłada się na realne korzyści ekonomiczne dla przedsiębiorstw.

ROCm 7.0 wprowadza ulepszone prymitywy uwagi i wnioskowania oraz techniki rzadkich mieszanin ekspertów. Te zaawansowane algorytmy pozwalają na bardziej efektywne wykorzystanie dostępnych zasobów obliczeniowych. Szczególnie ciekawe są optymalizacje dla mechanizmów uwagi, czyli kluczowego elementu architektur transformerowych, które stanowią podstawę najpopularniejszych obecnie modeli AI, od ChatGPT po Claude.

Nowoczesne systemy AI rzadko działają na pojedynczych procesorach. ROCm 7.0 wprowadza komunikację GPU-direct i rozproszone wnioskowanie między węzłami z kompatybilnością vLLM-d i DeepEP. Oznacza to, że obliczenia mogą być efektywnie rozdzielane między wiele kart graficznych, nawet znajdujących się w różnych serwerach. Dla administratorów infrastruktury AMD przygotowało AMD Resource Manager i nowy AI Workbench, czyli narzędzia do orkiestracji i monitorowania klastrów obliczeniowych dedykowanych sztucznej inteligencji.

Platforma nie ogranicza się wyłącznie do serwerów. Rozszerzone wsparcie dla procesorów Ryzen AI i kart graficznych Radeon RX umożliwia programistom tworzenie spójnych protoków od urządzeń brzegowych po chmury obliczeniowe.

Czytaj też: Intel poprawia wydajność GPU Xe3 w Panther Lake. Sterowniki Mesa 3D zyskują do 18% w grach

To szczególnie ważne dla firm, które chcą wdrażać AI na różnych poziomach swojej infrastruktury – od laptopów pracowników po serwery w centrach danych. Dodatkowo AMD nie zapomina o praktycznych aspektach wdrażania. Firma udostępnia gotowe obrazy Docker z przykładami skwantyzowanych modeli oraz przygotowane stosy dla popularnych frameworków jak SGLang, vLLM, Megatron-LM czy Jax.

HIP 7.0 zapewnia ulepszoną przenośność kodu, co ma ułatwić migrację aplikacji między różnymi ekosystemami sprzętowymi. Dodatkowo AMD Quark oferuje otwarty zestaw narzędzi do optymalizacji modeli, w tym techniki kwantyzacji i przycinania. Choć AMD ma przed sobą długą drogę, by dogonić lidera rynku, pierwsze sygnały są obiecujące. Szczególnie w kontekście rosnących kosztów rozwiązań konkurencji, otwarta platforma AMD może okazać się atrakcyjną alternatywą dla przedsiębiorstw szukających efektywnych kosztowo rozwiązań AI.